Facebook: 583 milioni di account falsi cancellati in tre mesi

Sono 583 milioni i fake account di Facebook rimossi nei primi 3 mesi del 2018. Molta strada da fare ancora su violenza e incitamento all’odio.

In una nota rilasciata ieri nel blog ufficiale, Facebook ha dichiarato di aver rimosso 837 milioni di fake news nel primo trimestre del 2018. La quasi totalità, specifica l’azienda, è stata trovata e contrassegnata prima che qualcuno segnalasse i singoli post e link.

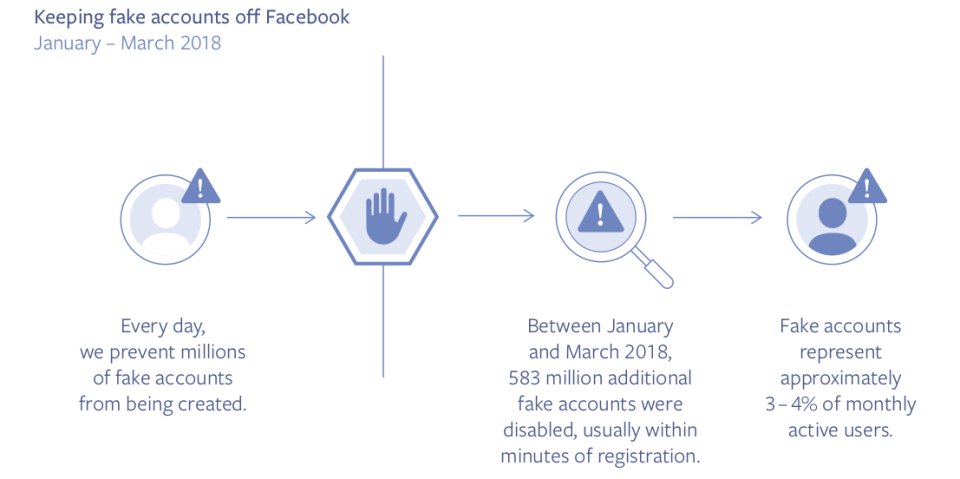

Dopo aver fatto chiarezza sui processi di revisione dei contenuti e annunciato maggiori possibilità per gli utenti, Facebook ha pubblicato un report che illustra i risultati dell’applicazione degli Standard della Comunità. La maggior parte degli sforzi aziendali ha riguardato l’individuazione di account fasulli, dai quali partono la stragrande maggioranza delle notizie false: sempre nel primo semestre di quest’anno sono stati disattivati circa 583 milioni di account falsi, la maggior parte dei quali bloccati entro pochi minuti dalla loro creazione.

Sempre nei primi tre mesi dell’anno, Facebook stima che siano ancora falsi circa il 3-4% degli account attivi. Sono circa 21 milioni i contenuti di nudo di adulti o pornografici rimossi, il 96% dei quali rilevati dagli algoritmi del social prima di essere segnalati dagli utenti reali: su ogni 10.000 contenuti visualizzati, 7-9 riguardavano contenuti che violano gli standard.

Gli standard di Facebook: le 6 aree di intervento

L’applicazione delle regole comunitarie di Facebook copre sei aree: violenza esplicita, nudo (adulti), atti sessuali, propaganda terroristica, incitamento all’odio, spam e account falsi. La maggior parte delle azioni intraprese da Facebook è mirata a colpire proprio i fake account, che generano a loro volta notizie false.

Facebook, però, ha ancora molti passi da fare sul riconoscimento della violenza e dell’incitamento all’odio, si legge nel blog:

La nostra tecnologia ancora non riesce a funzionare in maniera del tutto efficace ed è necessario l’intervento dei nostri team di revisione. L‘intelligenza artificiale non è ancora sufficiente per identificare se qualcuno sta incitando all’odio o se sta semplicemente descrivendo qualcosa che ha vissuto per denunciare pubblicamente il problema. Più in generale, […], la tecnologia necessita di un gran numero di dati di supporto per riuscire a riconoscere modelli significativi di comportamento, che noi spesso non abbiamo per lingue meno diffuse o per i casi che non vengono segnalati spesso.